2026年是数据经济发展的一个关键节点。随着人工智能模型日趋复杂,市场竞争日益激烈,对及时、准确且海量的数据集(通常被称为“另类数据”)的需求空前高涨。网络爬虫(即从网站自动提取数据)不再是一项边缘IT技能,而是商业智能的核心能力。

但并非所有网络爬虫项目都一样。到2026年,真正有利可图的项目在于那些能够处理动态内容、突破高级反机器人防御机制并提供可供人工智能/机器学习立即使用的数据的项目。

这篇全面的指南深入探讨了15种高利润的网络爬虫策略,这些策略技术难度高,但能带来丰厚的经济回报。我们将探讨所需的技术栈、您将面临的常见障碍,以及如何成功驾驭现代网络数据提取的复杂世界。

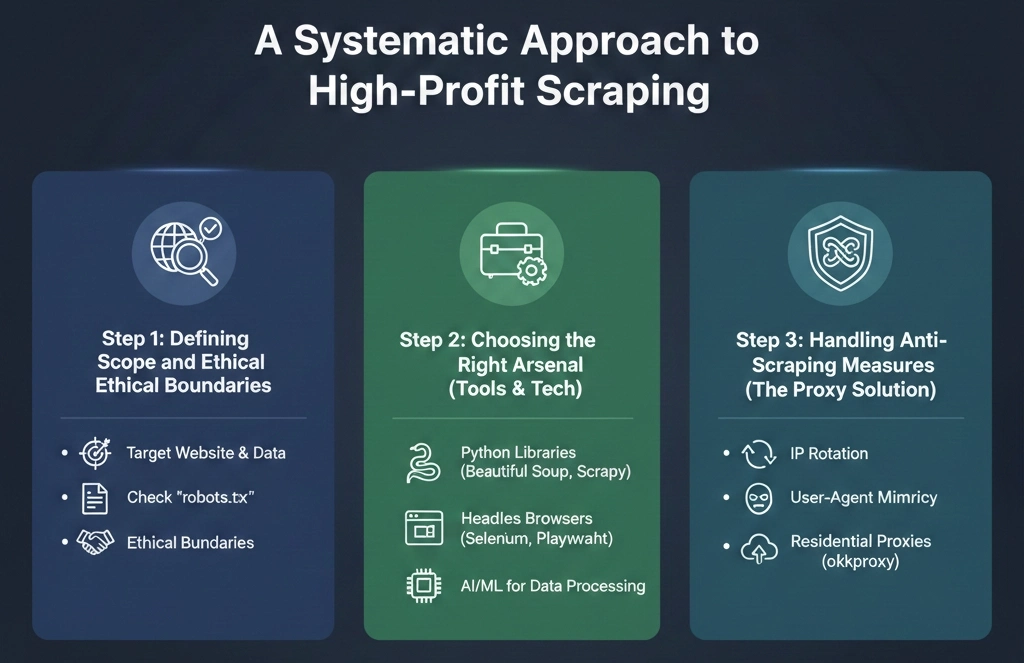

基础:高利润数据抓取的系统方法

要想获得高利润的网络爬虫项目,仅仅掌握 Python 语言是不够的。它需要一套结构化、符合伦理且技术上稳健的方法论。借鉴顶级数据咨询公司成功的模式,可以确保您的项目具有可扩展性、可持续性和合法合规性。

第一步:界定范围和伦理界限

在编写任何一行代码之前,必须对项目进行细致的定义。

确定目标网站和数据:哪些网站拥有最有价值的数据?对于价格监测项目,目标可能是像 Target 这样的大型零售商,这就需要专门的目标抓取技术。

确定精确的数据点:提取的数据必须能够立即投入使用。这包括识别具体元素,例如产品名称、价格、评论或 B2B 联系信息(zoominfo 抓取)。

请检查 robots.txt 文件和服务条款 (ToS):合乎道德的网页抓取意味着尊重网站的规则。虽然服务条款的限制经常在法庭上受到质疑,但首先遵守规则始终是最佳实践。

第二步:选择合适的装备(工具和技术)

现代网站的复杂性——大量的 JavaScript 渲染、单页应用程序 (SPA)——决定了工具的选择。

对于静态内容:Python 结合 Requests 和 Beautiful Soup 仍然是简单页面的标准。

对于大规模/复杂的数据抓取:Scrapy 是行业标准的高性能框架。

对于动态内容(JavaScript 密集型):Selenium、Puppeteer 或 Playwright 等库必不可少。为了在这些复杂的环境中实现最大程度的隐蔽性和效率,专业的无头浏览器和工具(例如功能强大的 aezakmi 浏览器)正成为经验丰富的数据提取人员的首选解决方案。

步骤 3:处理反爬虫措施(代理方案)

高利润网络爬虫面临的最大障碍是反机器人技术。如今,网站都受到复杂系统的保护,这些系统能够检测并阻止自动化流量。要克服这些障碍,需要强大的代理基础设施和智能的机器人管理。

针对特定保护层(例如那些专注于绕过 perimeterx 的工具)设计的工具需要一种复杂的方法,包括轮换用户代理、cookie 管理,以及至关重要的高质量代理。

这时,像okkproxy这样的专业服务商就显得不可或缺了。对于大型项目,他们的住宅和移动代理提供真实、未被标记的IP地址,使抓取流量与人类访客的流量难以区分。无论您需要处理成千上万个抓取电商数据的请求,还是开展精准的营销活动,okkproxy可靠的住宅代理都能确保您的脚本畅通无阻,相比那些经常被标记的普通数据中心IP列表,这无疑是一项关键优势。选择此类专业服务,对于那些寻求特定区域覆盖或具有竞争力的价格模式的用户来说,也是绝佳的优质数据替代方案。

2026 年 15 个高利润网络爬虫项目

这些项目之所以被选中,是因为它们兼具高度复杂性(限制了竞争)和高潜在财务回报(由行业对独特数据的需求驱动)。

1. 电子商务价格和库存监控

利润视角:零售商和套利者愿意支付高价购买实时竞争情报。了解竞争对手何时调整价格或缺货,有助于他们进行动态价格调整,实现利润最大化。

技术重点:需要处理复杂的商品目录、网站搜索功能和验证码。专门用于抓取 eBay 商品信息或对美国主要零售商进行大规模定向抓取的脚本涉及会话 cookie 和地理位置定向的管理。

2. B2B 线索生成与提炼

盈利视角:销售和营销团队依赖于准确、最新的联系人和公司数据。抓取公开的专业名录和企业网站可以创建极具价值的定制化潜在客户名单,远胜于通用数据库。

技术重点:这直接涉及从 Zoominfo(或类似的 B2B 数据提供商)抓取公开的个人资料、公司新闻和招聘信息。这通常是一个高度安全的目标,需要顶级住宅代理。

3. 社交媒体情绪和趋势分析

盈利角度:实时了解公众舆论对于危机管理、政治竞选和产品发布至关重要。

技术重点:需要处理 API 受限的平台和非公开用户资料。针对特定平台的爬虫,例如专门的 Truth Social 爬虫或 Snapchat 爬虫,面临着独特的登录和动态内容方面的挑战。数据提取需要谨慎的身份验证,并能应对快速变化的页面结构。

4. 供应链和全球产品采购数据

盈利角度:全球制造商和物流公司需要来自主要国际市场的原材料成本和产品供应情况的实时数据。

技术重点:需要掌握阿里巴巴爬虫,以跟踪数百万种产品的供应商定价、最小订购量 (MOQ) 和发货周期,通常需要地理位置代理来访问特定区域的目录。

5. 就业市场和薪酬基准分析

盈利角度:人力资源咨询公司和大型企业需要准确的薪酬数据来保持竞争力并防止人才流失。

技术要点:由于严格的速率限制和 IP 封禁,创建可靠的 Glassdoor 评论抓取工具或 LinkedIn 职位发布抓取工具非常复杂。这需要强大的错误处理机制和数千个 IP 地址的轮换,通常依赖于okkproxy 的轮换住宅 IP 地址池来模拟独立用户。

6. 将用户生成内容 (UGC) 聚合用于人工智能训练

盈利角度:对用于训练大型语言模型(LLM)和专用人工智能的干净、带标签数据有着巨大的需求。来自小众社区的高质量用户生成内容(UGC)具有不可估量的价值。

技术重点:抓取小众社区和会员平台的数据。例如,可靠的 Patreon 网站抓取服务需要应对付费墙、登录流程和复杂的论坛结构,通常需要动态渲染工具。

7. 用于交易的替代性财务数据

盈利角度:对冲基金和量化交易员愿意花高价购买与市场走势相关的独特、非传统的数据点,例如停车场交通流量的卫星数据或当地评论网站上的人流量数据。

技术重点:挑战在于每天提取、清理和验证数百万条记录,这需要最大限度地提高数据管道效率。

8. 品牌保护和版权侵权检测

盈利角度:监控网络,查找未经授权使用品牌标识、受版权保护的材料或假冒产品信息的行为。

技术重点:涉及抓取图像 URL 并将其输入计算机视觉模型进行分析,这需要大量的带宽和并发连接。这包括监控诸如抓取 Facebook Marketplace 等平台,以检测假冒商品信息。

9. 产品评论聚合在竞争情报中的应用

盈利角度:对产品评论进行深入分析,可以深入了解功能缺陷、客户满意度和竞争对手的弱点。

技术重点:这通常涉及使用像快照抓取器这样的通用工具,从各种零售和评论平台快速收集评论,并将不同的评论格式标准化为统一的数据集。

10. 房地产投资数据收集器

盈利角度:为投资者识别不良资产、跟踪租金收益率并监控超本地市场趋势。

技术重点:处理高度本地化且不断更新的房地产列表。数据通常需要通过 AJAX 加载或进行数据访问,因此需要 JavaScript 渲染。

11. 旅游和酒店价格一致性监测

盈利角度:酒店和航空公司必须确保其价格在所有预订渠道(在线旅行社)上保持一致。价格差异会导致罚款。

技术重点:需要地理定位和会话管理来模拟来自不同地点和用户设备的预订,因此代理质量至关重要。

12. 本地商家名录审核

盈利角度:营销机构使用抓取的数据来审核其客户在数百个目录(Yelp、Google Maps 等)中的本地引用,以确保名称、地址、电话 (NAP) 数据的一致性。

技术重点:大量小型、本地化的请求,因此高效的代理轮换对于避免临时封禁至关重要。

13. 监管合规和法律监督

盈利角度:律师事务所和合规部门需要监控特定政府或监管机构的网站,以了解政策变化、新文件或竞争对手的违规行为。

技术重点:这些网站通常比较老旧,缺乏标准化,并且使用非 API 结构(PDF、旧式 HTML 表单),因此需要复杂的解析器逻辑。

14. 学术研究数据采集

盈利角度:从大学图书馆和学术出版商收集科学论文、引文和元数据,用于元分析。

技术重点:绕过付费墙(通常需要 Shibboleth 或机构登录)和高度结构化的引用格式,如果可用,可能需要 API 交互。

15. 财经新闻和媒体趋势分析

盈利角度:追踪特定新闻关键词与股票表现的相关性。这需要抓取小众财经媒体的数据并汇总政治情绪。

技术重点:注重速度和低延迟,因为数据在发布后价值会迅速下降。

技术深度解析:克服现代网络障碍

要成功执行这些高利润项目,您必须在处理最具挑战性的反抓取技术方面展现出高度的专业知识、权威性和可信度。

| 项目类型 | 盈利潜力(1-5) | 技术难度(1-5) | 反机器人的关键挑战 | 必备工具/服务 |

| B2B潜在客户开发 (zoominfo抓取) | 5 | 5 | 速率限制、验证码 | okkproxy 住宅代理 |

| 电子商务价格 (抓取 eBay 商品信息) | 4 | 4 | 复杂的IP指纹识别 | okbrowser 用于隐身 |

| 社会情绪 (真实社会数据抓取器) | 3 | 4 | 登录门槛、API限制 | 会话管理 |

| 供应链 (阿里巴巴爬虫) | 4 | 3 | 地理封锁,大容量 | 高速数据中心代理 |

| 评论聚合 (Glassdoor 评论抓取器) | 5 | 5 | PerimeterX 绕过,高级机器人 | 专用解封解决方案 |

反机器人规避方面的专业知识

现代网络爬虫本质上就是反机器人技术专家。像 PerimeterX 或 Cloudflare 的 Bot Fight Mode 这样的解决方案会主动分析流量模式、浏览器标头,甚至鼠标移动轨迹。简单的脚本会被立即拦截。

成功规避需要:

- 头部和指纹模拟: 生成逼真的浏览器头部、屏幕分辨率和 WebGL 指纹。

- JavaScript 执行:运行完整的无头浏览器(例如,通过 aezakmi 浏览器集成)来执行所有必要的 JavaScript,证明您不是一个简单的脚本。

- IP质量: 这是不容妥协的一步。如果您的IP地址被列入黑名单,再怎么修改请求头也无济于事。因此,像okkproxy这样提供干净、来源可靠的住宅和移动IP地址池的高质量服务商就显得尤为重要。对于IP质量至关重要的项目而言,它们提供了最可靠的数据替代方案之一。

关于2026年网络爬虫的常见问题解答

问:网络爬虫合法吗?

答:一般来说,抓取公开数据是合法的,尤其是在像hiQ Labs诉LinkedIn这样的里程碑式判决之后。但是,抓取需要登录才能访问的数据、违反明确的服务条款,或者抓取过多数据导致服务器损坏,都可能违法。务必查看robots.txt文件,并始终将道德底线放在首位。

问:为什么我需要担心 PerimeterX 旁路?

答:PerimeterX 是领先的企业级机器人防护服务之一。它利用行为分析和机器学习等先进技术保护高价值目标(例如电商网站或金融平台)。要抓取这些目标的数据,您必须实施超越基本代理轮换的复杂隐蔽措施,这通常需要专门的、专用的解封服务。

问:对于像 Patreon 数据抓取网站这样的项目,处理登录墙和付费墙的最佳方法是什么?

答:这需要分多步进行:1)安全地管理有效凭证。2)使用无头浏览器(例如 Playwright/Puppeteer)像真人一样浏览登录表单,包括处理重定向和双因素身份验证提示。3)维护会话 cookie,并将其与 okkproxy 等服务的粘性住宅代理结合使用,以确保会话的连续性。

问:什么是刮刀?它有什么用途?

答:所谓“快速抓取工具”(通常指快速或多功能的抓取工具),是指能够快速适应并从各种目标抓取数据的工具或脚本,这些目标可能没有公开明确的反机器人措施。它适用于规模较小、数据量较大的竞争情报任务,例如收集产品元数据或从规模较小、受保护的供应商处收集评论。

结论:2026 年的数据淘金热

2026 年高利润的网络爬虫领域将以复杂性、数据量和精准度为特征。过去那种只需简单请求和 BeautifulSoup 脚本就能获得数百万数据的时代已经一去不复返了。如今,盈利能力直接取决于你获取他人无法获取的数据的能力。

通过专注于具有挑战性的目标——无论是目标抓取产品数据、像 zoominfo 抓取这样的专业 B2B 数据提取,还是通过 truth social scraper 进行社交分析——并利用必要的技术实力,包括来自 okkproxy 等行业领导者的强大代理解决方案,您可以将自己置于另类数据经济的前沿。

数据就是新的石油,而高利润的网络爬虫则是未来的勘探者。以上列出的15个项目代表了您下一个成功的数据提取项目的最佳沃土。