数据解析是将原始网页内容转化为有价值洞察的重要步骤。无论是采集 HTML 页面、API 数据还是数据库内容,解析都能把非结构化数据整理成可分析的结构化结果。然而,在大规模采集中,IP 封禁、地域限制、速率限制和反爬机制常常成为瓶颈。

这时,代理服务发挥了关键作用。OkkProxy 提供稳定的代理解决方案,帮助你绕过这些障碍,实现高效、稳定、匿名的数据采集与解析。

什么是数据解析?

数据解析指的是将原始数据(如 HTML、JSON、XML)转换为结构化格式(如 CSV、数据库)。 它能从冗余的网页源码中提取有价值的信息,形成可用于分析的清洗数据。

数据解析的重要性

解析后的数据广泛应用于多个场景:

– 竞品分析:采集对手价格、库存、促销信息

– SEO 监控:跟踪关键词排名和搜索引擎表现

– 市场调研:收集消费者评论、偏好与反馈

– 数据挖掘:从大规模网页数据中提炼趋势与模式

数据解析的挑战

1. 地域限制与 IP 封禁

部分网站限制特定地区的访问,或对单一 IP 的频繁请求进行封禁。

2. 反爬机制

CAPTCHA、速率限制和 Bot 检测等会影响采集效率。

3. 数据不一致

不同网站数据格式复杂,解析后常需额外清洗。

4. 复杂网页结构

HTML 层级繁琐,定位目标数据点难度大。

OkkProxy 如何解决这些问题

1. 旋转代理避免封禁 OkkProxy 提供自动切换的轮转代理,让每次请求都使用不同 IP,有效降低被封风险。

2. 全球代理资源突破地域限制

覆盖欧美、亚洲等地区,轻松获取跨区域数据。

3. 高速采集

并发代理节点支持大规模实时数据抓取,提升解析速度。

4. 匿名访问,防止追踪

隐藏真实 IP,保护隐私,避免网站检测到爬虫活动。

5. 绕过反爬机制

OkkProxy 的住宅与 ISP 代理可应对验证码与 Bot 检测,保持采集不中断。

如何使用 OkkProxy 进行数据解析

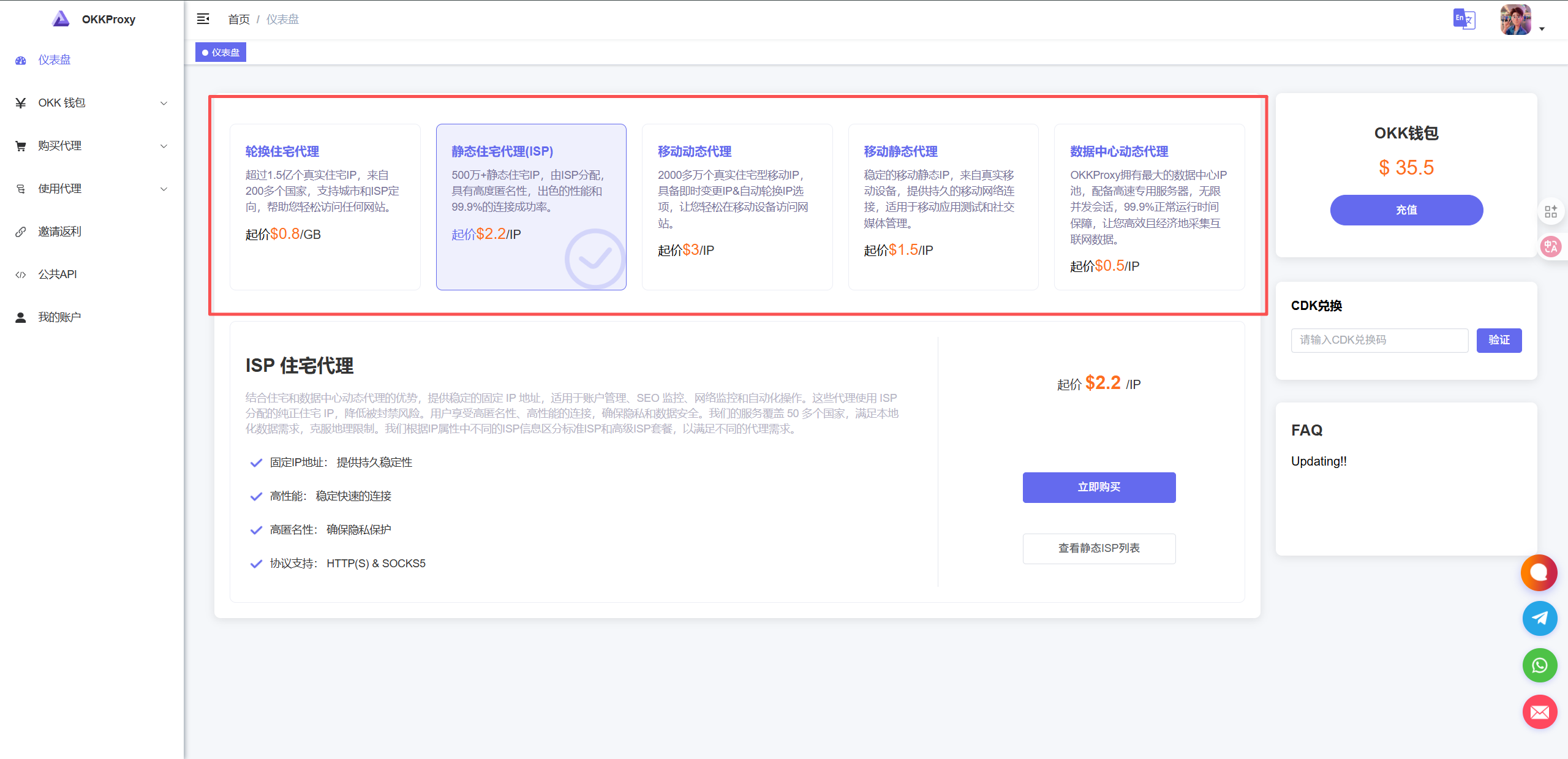

1. 选择代理类型:根据需求选择住宅代理或数据中心代理。

2. 获取代理信息:注册后即可获取全球代理节点 IP 和端口。

3. 集成到爬虫工具:支持 Scrapy、Selenium、Puppeteer 等常见框架。

4. 运行采集脚本:在代理保护下进行爬取与解析。

5. 存储与分析:将解析结果保存为 CSV、JSON,便于进一步分析。

结论

数据解析是从原始内容获取洞察的必经之路,但过程中难免遇到 IP 限制与反爬挑战。OkkProxy 通过轮转代理、全球覆盖和高速节点,帮助用户快速、稳定、匿名地完成数据采集与解析,适用于竞品监控、SEO 分析和市场调研等多种业务场景。

常见问题 FAQ

Q: 什么是数据解析? A: 数据解析是将 HTML、JSON、XML 等原始数据转化为结构化结果(如 CSV、数据库)的过程。

Q: 如何进行数据解析?

1. 选择解析工具(如 BeautifulSoup、JSON.parse、XML 解析器)

2. 获取原始数据(来自网页、API、文件)

3. 定位并提取目标字段

4. 使用工具提取并清洗数据

5. 保存为可用格式(CSV、JSON 等)